Telecamere in streaming 4x con portaschede di dimensioni ridotte: Prototipo veloce

I componenti visivi integrati sono sempre più diffusi e vengono inclusi in una grande quantità di applicazioni. Queste applicazioni hanno in comune la necessità di contenere molte funzionalità in poco spazio. Questo è anche molto vantaggioso perché spesso tali sistemi prendono decisioni in circostanze al limite. Teledyne FLIR ha introdotto la soluzione integrata Quartet™ per TX2, al fine di abilitare tali sistemi, compresa la possibilità di realizzare rapidamente prototipi. Questo portaschede personalizzato consente la facile integrazione fino a 4 telecamere per la visione artificiale USB3 a larghezza di banda completa. Include l’acceleratore hardware per il deep learning NVidia Jetson ed è pre-integrato con l’SDK Spinnaker® di Teledyne FLIR. Questo è anche molto vantaggioso, perché spesso tali sistemi prendono decisioni in circostanze al limite, soprattutto nell’ambito di ispezioni, robotica mobile, sistemi di traffico e vari tipi di veicoli senza pilota.

In questo pratico articolo evidenziamo le capacità di Quartet descrivendo i passi intrapresi nello sviluppo di un prototipo ispirato al traffico ITS che esegue simultaneamente quattro applicazioni, tre delle quali utilizzano il deep learning:

- Applicazione 1: Riconoscimento delle targhe tramite deep learning

- Applicazione 2: Categorizzazione del tipo di veicolo tramite deep learning

- Applicazione 3: Classificazione del colore del veicolo tramite deep learning

- Applicazione 4: Visione attraverso il parabrezza (oltre il riverbero e il riflesso)

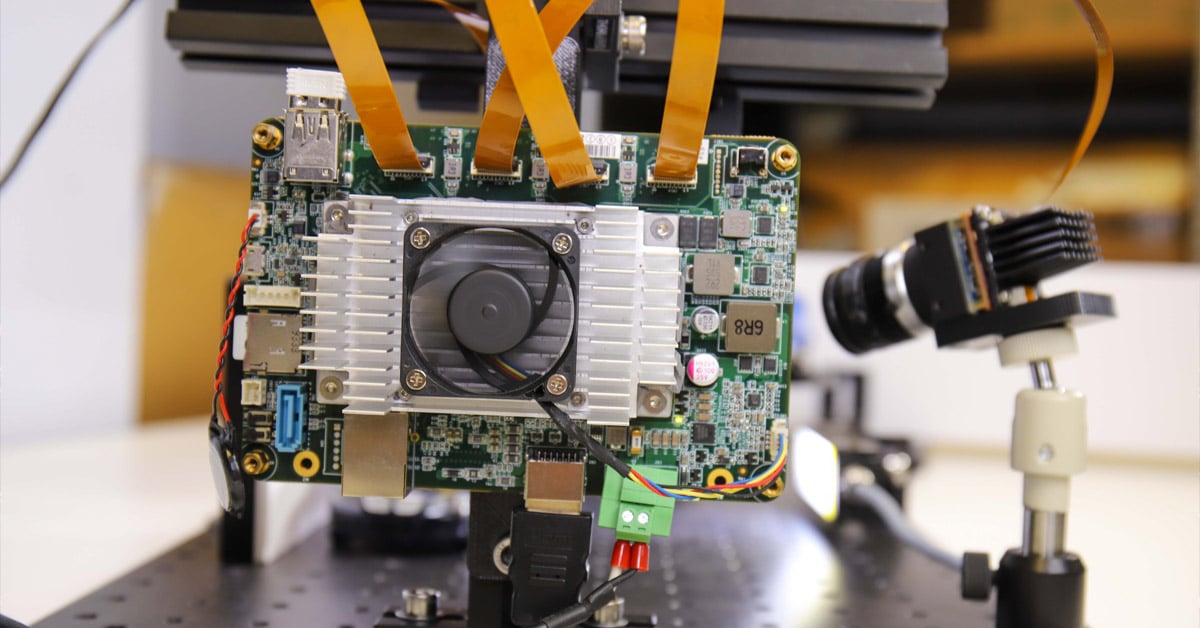

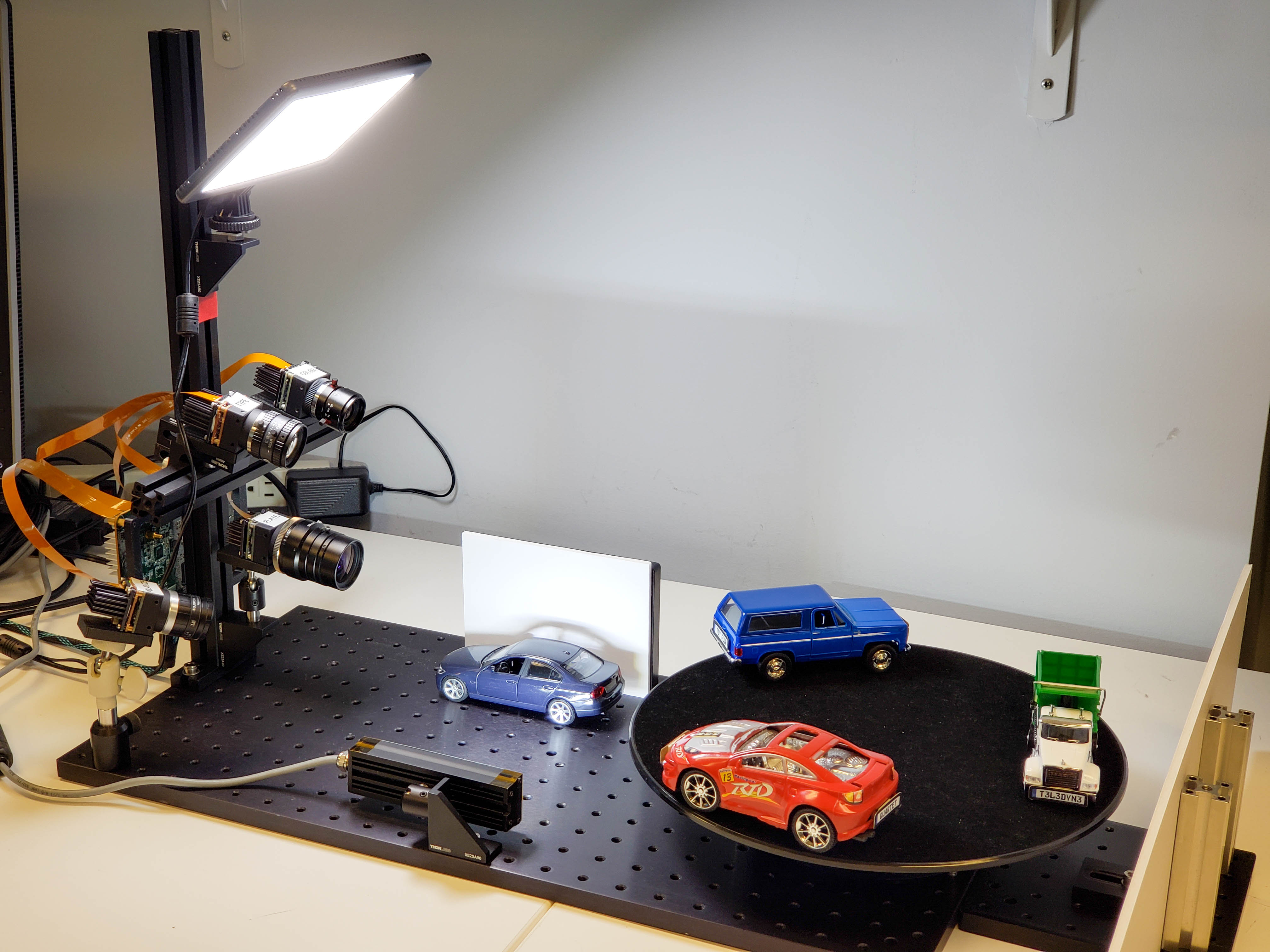

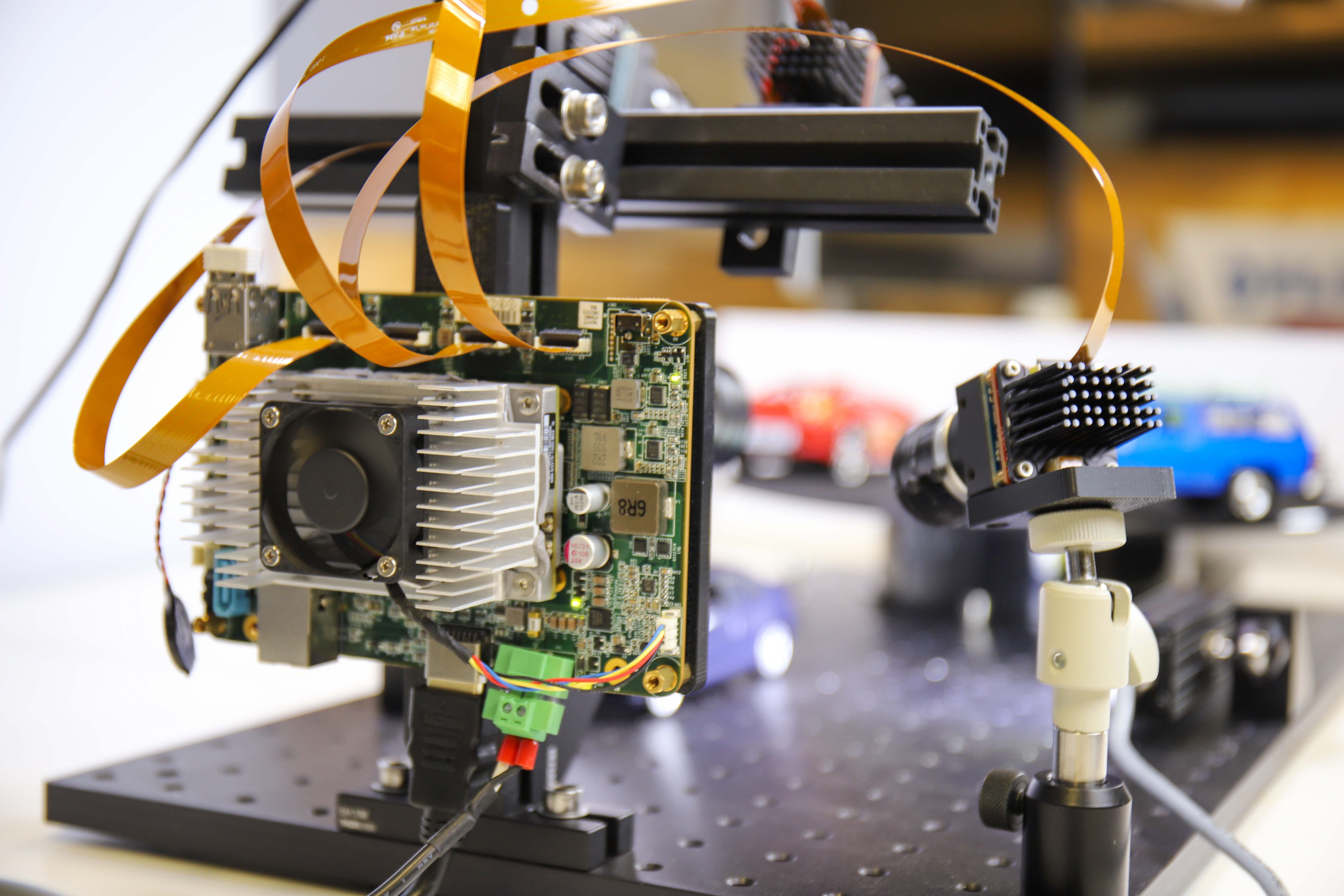

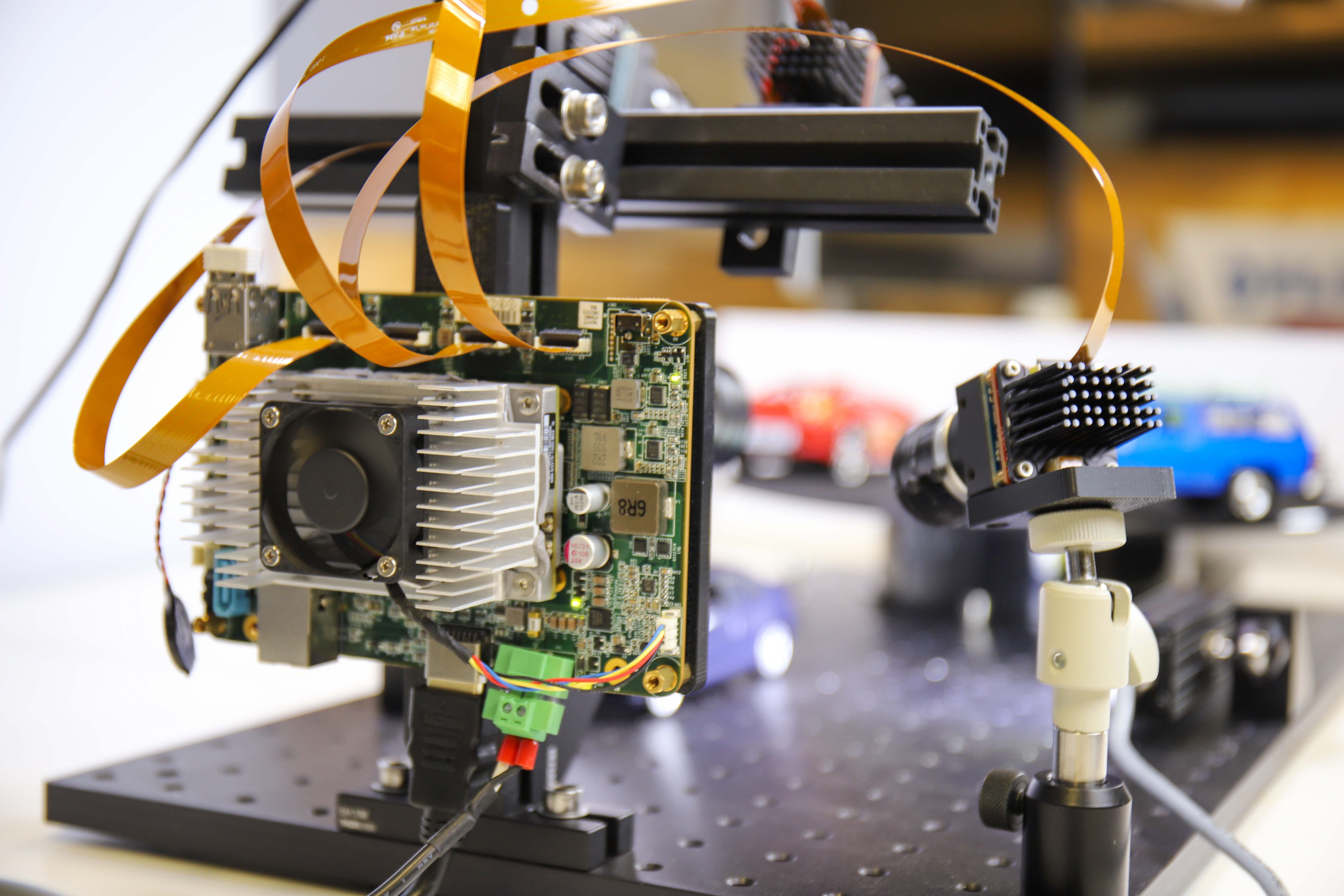

Figura 1: Configurazione del prototipo per tutte e quattro le applicazioni

Elenco degli acquisti: Componenti hardware e software

1) SOM per l’elaborazione:

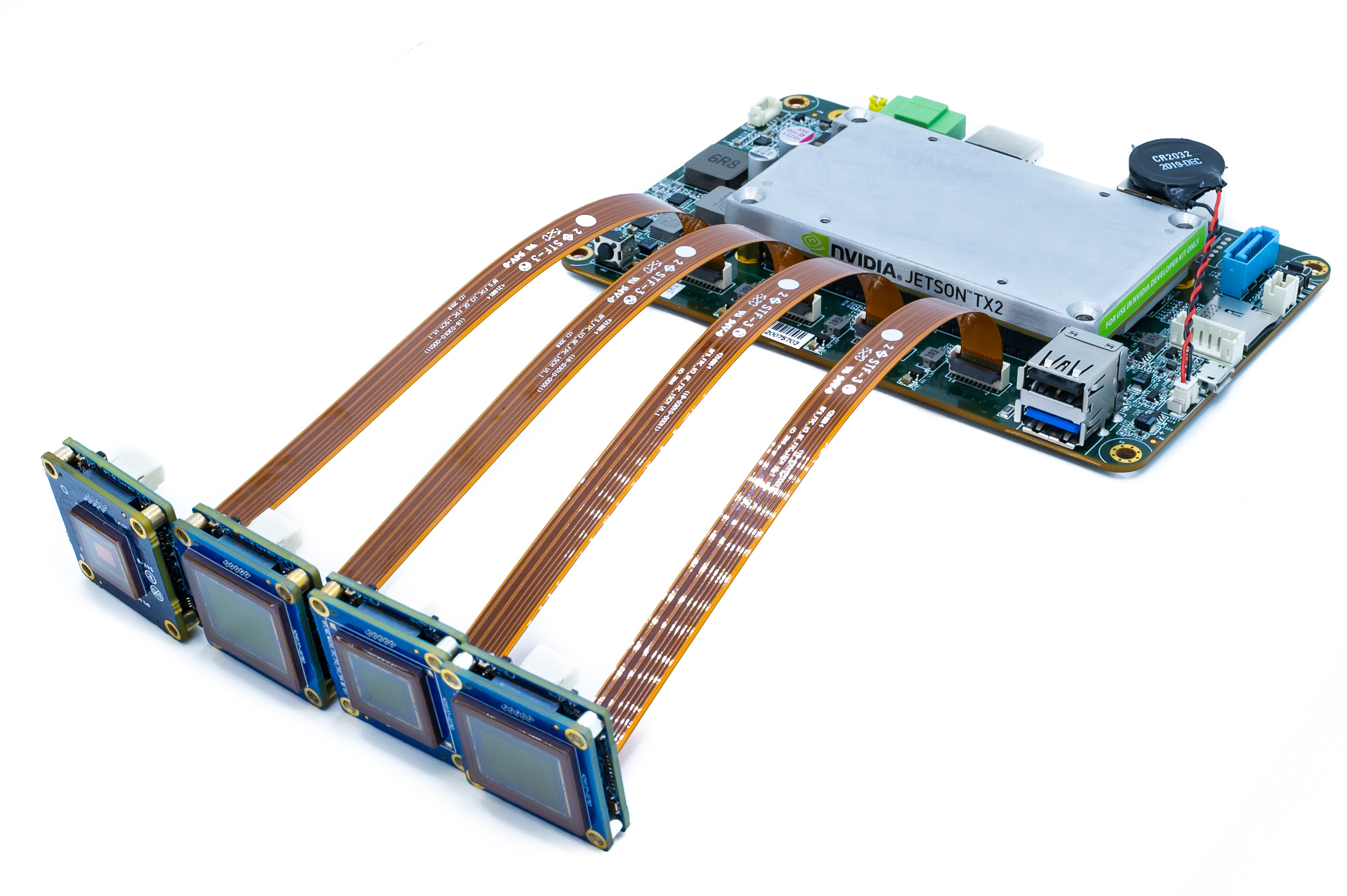

Il nuovo portaschede Teledyne FLIR Quartet per TX2 include:

- 4x connettori TF38 con controller USB3 dedicati

- Modulo Nvidia Jetson TX2

- Dotato di un potente e facile SDK Spinnaker di Teledyne FLIR per garantire una compatibilità plug-and-play con le telecamere board level Teledyne FLIR Blackfly S

- L’acceleratore hardware deep learning Nvidia Jetson consente di realizzare un sistema decisionale completo su una singola scheda compatta.

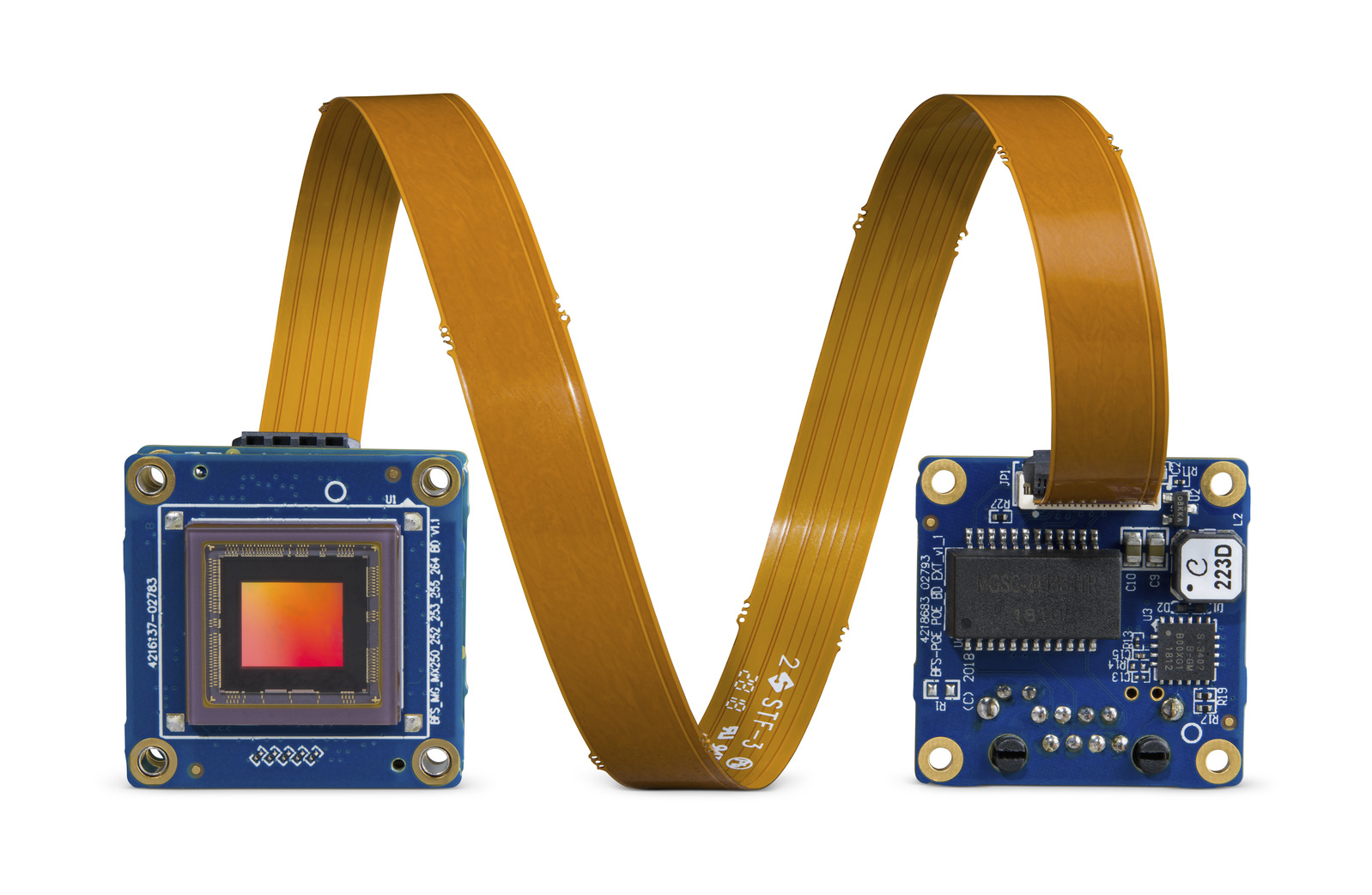

Figura 2: Immagine della Soluzione integrata Quartet con TX2 assieme a 4 telecamere Blackfly S e 4 cavi FPC.

2) Telecamere e cavi

- 3x telecamere standard Teledyne FLIR Blackfly S USB3 board level che utilizzano lo stesso set di funzioni avanzate della versione con custodia applicato ai più recenti sensori CMOS e per un’integrazione perfetta con Quartet

- 1x telecamera personalizzata: Telecamera Blackfly S USB3 board level con sensore polarizzato Sony IMX250MZR

- Cavi: I cavi TF38 FPC consentono di trasmettere alimentazione e dati su un unico cavo per risparmiare spazio

Figura 3: Telecamera Blackfly S board level con cavo FPC

Iscriviti per ricevere altri articoli come questo

3) Illuminazione: Luci LED per fornire un’illuminazione sufficiente a evitare l’effetto mosso delle targhe.

Applicazione 1: Riconoscimento delle targhe tramite deep learning

Tempo di sviluppo: 2-3 settimane principalmente per renderlo più robusto e veloce

Immagini di formazione: Incluso con LPDNet

Per il riconoscimento delle targhe, abbiamo implementato un modello pronto all’uso Nvidia di rilevamento targhe (LPDNet) deep learning, che rileva la posizione delle targhe. Per riconoscere i numeri e le lettere abbiamo utilizzato il motore OCR open source Tesseract. Questo modello è una telecamera a colori Blackfly S board level da 8,9 MP (BFS-U3-88S6C-BD) con sensore Sony IMX267. Per accelerare le prestazioni abbiamo limitato l’ambito di interesse al rilevamento della targa e abbiamo applicato il rilevamento per migliorare la robustezza. L’output include i riquadri di delimitazione delle targhe con i corrispondenti caratteri.

Figura 4: Streaming con i riquadri di delimitazione delle targhe e dei loro caratteri.

Applicazione 2: Categorizzazione del tipo di veicolo tramite deep learning

Tempo di sviluppo: ~12 ore, compresi la raccolta e lo sviluppo delle immagini

Immagini di formazione: ~300

Per la categorizzazione del tipo di veicolo, utilizzando l’apprendimento induttivo, abbiamo programmato il nostro modello di rilevamento degli oggetti Deep Learning per rilevare le tre auto giocattolo utilizzate, ovvero SUV, berlina e camion. Abbiamo raccolto circa 300 immagini di formazione scattandole a varie distanze e angolazioni, che consentono la configurazione. Questo modello è una telecamera a colori Blackfly S board level da 5 MP (BFS-U3-51S5C-BD) con sensore Sony IMX250. L’annotazione dei riquadri di delimitazione delle auto giocattolo ha richiesto circa 3 ore. Abbiamo eseguito l’apprendimento induttivo per programmare il modello di rilevamento oggetti MobileNet SSD che ha richiesto circa mezza giornata su una GPU Nvidia GTX1080 Ti. Con l’acceleratore hardware GPU, il modulo Jetson TX2 è in grado di eseguire l’inferenza di deep learning in modo efficiente e di produrre riquadri di delimitazione delle auto assieme ai corrispondenti tipi di veicolo.

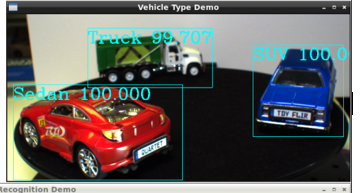

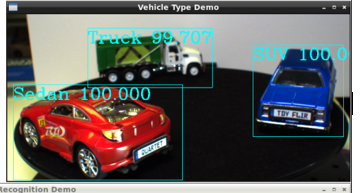

Figura 5: Streaming con riquadri di delimitazione dell’individuazione dei tipi di veicolo preimpostati e coefficiente di affidabilità

Applicazione 3: Classificazione del colore del veicolo tramite deep learning

Tempo di sviluppo: Modello riutilizzato dall’ “applicazione della tipologia di veicolo” con 2 giorni aggiuntivi per classificare il colore, integrare e sottoporre a test

Immagini di formazione: Riutilizzo delle stesse 300 immagini per l’“applicazione Tipo di veicolo”

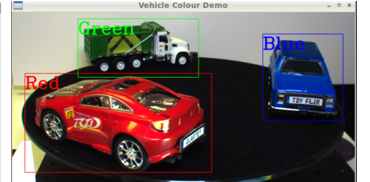

Per la classificazione del colore del veicolo, abbiamo eseguito lo stesso modello di rilevamento oggetti deep learning di cui sopra, seguito dall’analisi delle immagini sui riquadri di delimitazione. L’output include i riquadri di delimitazione delle auto con i relativi colori. Questo modello è una telecamera a colori Blackfly S board level 3 (BFS-U3-32S4C-BD) con sensore Sony IMX252.

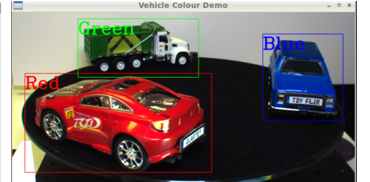

Figura 6: Streaming con riquadri di delimitazione e individuazione dei colori preimpostati

Applicazione 4: Visione attraverso il parabrezza (oltre il riverbero e il riflesso)

La riduzione del riverbero è fondamentale per le applicazioni legate al traffico, ad esempio, vedere attraverso il parabrezza per monitorare le corsie HOV, verificare l’uso delle cinture di sicurezza e persino dei cellulari durante la guida. A questo scopo, abbiamo realizzato una speciale telecamera Blackfly S USB3 board level con sensore Sony IMX250MZR a polarizzazione da 5 MP. Questa telecamera di polarizzazione board level non è un prodotto standard, ma Teledyne FLIR è in grado di scambiare facilmente diversi sensori per offrire opzioni di telecamera personalizzate e mostrarne la capacità di rimozione del riverbero. Abbiamo semplicemente trasmesso in streaming le immagini della telecamera tramite la GUI SpinView di Teledyne FLIR, che offre varie opzioni di “algoritmo di polarizzazione”, come la modalità quad, la modalità di riduzione del riverbero, per mostrare la riduzione del riverbero su un’auto ferma.

Figura 7: La Spinnaker SDK GUI offre varie opzioni di “algoritmo di polarizzazione” come la modalità quad, la modalità di riduzione del riverbero, per mostrare la riduzione del riverbero su un’auto ferma. La modalità quad mostra le 4 immagini corrispondenti ai quattro diversi angoli di polarizzazione.

Ottimizzazione generale del sistema

Anche se ciascuno dei quattro prototipi ha fornito buone prestazioni individuali, le prestazioni complessive sono risultate piuttosto insoddisfacenti, quando tutti i modelli di deep learning erano in esecuzione contemporaneamente. L’SDK TensorRT di Nvidia fornisce un ottimizzatore di inferenza di deep learning e il tempo di utilizzo dell’hardware Nvidia come il modulo Jetson TX2. Abbiamo ottimizzato i nostri modelli di deep learning utilizzando l’SDK TensorRT, ottenendo un miglioramento delle prestazioni di circa 10 volte. Sul lato hardware, abbiamo collegato un dissipatore di calore al modulo TX2 per evitare il surriscaldamento, essendo parecchio caldo con tutte le applicazioni in esecuzione. Alla fine, siamo riusciti a ottenere un buon frame rate con tutte e quattro le applicazioni in funzione: 14 fps per l’identificazione del tipo di veicolo, 9 fps per la classificazione del colore del veicolo, 4 fps per il riconoscimento automatico della targa e 8 fps per telecamera di polarizzazione.

Abbiamo sviluppato questo prototipo in un periodo di tempo relativamente breve, grazie alla facilità d’uso e all’affidabilità della soluzione integrata Quartet e delle telecamer Blackfly S board level. Il modulo TX2 con SDK Spinnaker preinstallato garantisce la compatibilità plug and play con tutte le telecamere Blackfly S board level. Queste possono trasmettere in modo affidabile alla massima larghezza di banda USB3 tramite la connessione TF38. Nvidia fornisce molti strumenti per facilitare lo sviluppo e l’ottimizzazione del modulo TX2. Il Quartet può essere acquistato online su flir.com e tramite i nostri uffici e la rete di distributori globali.

3) Lighting: LED lights to provide sufficient illumination to avoid motion blur for the license plates.

Application 1: License plate recognition using deep learning

Development time: 2-3 weeks primarily to make it more robust and run faster

Training Images: Included with LPDNet

For license plate recognition, we deployed an off-the-shelf License Plate Detection (LPDNet) deep learning model from Nvidia to detect the location the license plates. To recognize the letter & numbers we used the Tesseract open-source OCR engine. The camera is a Blackfly S board level 8.9 MP color camera (BFS-U3-88S6C-BD) with the Sony IMX267 sensor. We limited the region of interest for license plate detection to speed up performance and applied tracking to improve the robustness. The output includes bounding boxes of the license plates together with the corresponding license plate characters.

Figure 4: Streaming with bounding boxes of the license plates and license plate characters.

Application 2: Vehicle type categorization using deep learning

Development time: ~12 hours including image collection and annotation

Training Images: ~300

For vehicle type categorization, using transfer learning, we trained our own Deep Learning object detection model for the three toy cars used, namely SUV, sedan and truck. We collected approximately 300 training images of the setup, taken at various distances and angles. The camera is a Blackfly S board level 5 MP color camera (BFS-U3-51S5C-BD) with the Sony IMX250 sensor. We annotated the bounding boxes of the toy cars which took approximately 3 hours. We performed transfer learning to train our own SSD MobileNet object detection model which took around half a day on an Nvidia GTX1080 Ti GPU. With the GPU hardware accelerator, the Jetson TX2 module can perform deep learning inference efficiently and output bounding boxes of the cars together with the corresponding vehicle types.

Figure 5: Streaming with bounding boxes and pre-set vehicle types & confidence factor identified

Application 3: Vehicle color classification using deep learning

Development time: Re-used model from “Vehicle Type application” with additional 2 days to classify color, integrate & test

Training Images: Re-used same 300 images as “Vehicle Type application”

For vehicle color classification, we ran the same deep learning object detection model as above to detect the cars, followed by image analysis on the bounding boxes to classify its color. The output includes bounding boxes of the cars together with the corresponding vehicle colors. The camera is a Blackfly S board level 3 MP color camera (BFS-U3-32S4C-BD) with the Sony IMX252 sensor.

Figure 6: Streaming with bounding boxes and pre-set color types identified

Application 4: See through windshield (past reflection & glare)

Glare reduction is critical for traffic related applications such as seeing through a windshield to monitor HOV lanes, check for seatbelt compliance and even check for using their phones while driving. For this purpose, we made a custom camera by combining a Blackfly S USB3 board level camera with the 5MP polarization Sony IMX250MZR sensor. This board level polarization camera is not a standard product, but Teledyne FLIR is able to swap in different sensors easily to offer custom camera options to showcase its glare removal functionality. We simply streamed the camera images via Teledyne FLIR’s SpinView GUI, which offers various "Polarization Algorithm" options such as quad mode, glare reduction mode, to show the glare reduction on a stationary toy car.

Figure 7: Spinnaker SDK GUI offers various "Polarization Algorithm" options such as quad mode, glare reduction mode, to show the glare reduction on a stationary toy car. The quad mode shows the 4 images corresponding to the four different polarization angles.

Overall System Optimization

While each of the four prototypes worked well independently, we noticed that the overall performance was quite poor when all the deep learning models were running simultaneously. Nvidia’s TensorRT SDK provides a deep learning inference optimizer and runtime for Nvidia hardware such as the Jetson TX2 module. We optimized our deep learning models using the TensorRT SDK, resulting in around 10x performance improvement. On the hardware side, we attached a heat sink onto the TX2 module to avoid overheating, as it was quite hot with all the applications running. At the end, we managed to achieve good frame rates with all four applications running together: 14 fps for vehicle type identification, 9 fps for vehicle color classification, 4 FPS for automatic number plate recognition and 8 FPS for the polarization camera.

We developed this prototype within a relatively short period of time thanks to the ease-of-use and reliability of the Quartet Embedded Solution and Blackfly S board level cameras. The TX2 module with pre-installed Spinnaker SDK ensures plug & play compatibility with all the Blackfly S board level cameras which can stream reliably at full USB3 bandwidth via the TF38 connection. Nvidia provides many tools to facilitate development and optimization on the TX2 module. The Quartet is now available for purchase online on flir.com as well as through our offices and global distributor network.